Les News

Mois de Décembre 2014

2/1 Une paire gagnante : le satellite OCO-2 mesure la concentration en gaz carbonique de l’atmosphère et la fluorescence de la végétation

Les premières données du satellite Orbiting Carbon Observatory (OCO-2) viennent d’être analysées.

Lancé avec succès le 2 juillet 2014, il avait comme objectif d’observer la concentration en gaz carbonique de l’atmosphère et sa variabilité (voir News de juillet).

Ce gaz est en effet le principal responsable du réchauffement climatique en

cours, et si les processus naturels et les activités humaines qui en

constituent les sources pour l’atmosphère sont connus, leur variabilité l’est

beaucoup moins. Il en va de même pour les processus naturels, appelés

«puits» par lesquels le gaz carbonique est retiré de l’atmosphère.

Sources et puits agissent en permanence et souvent de façon simultanée sur le

contenu en gaz carbonique de l’atmosphère de telle sorte qu’il est la plupart

du temps impossible de distinguer leurs rôles respectifs dans les variations

qu’on observe à l’échelle de quelques jours ou d’une région.

Ce que l’on sait en effet de l’évolution de la teneur en gaz carbonique de

l’atmosphère provient d’un réseau de quelques dizaines d’observatoires

terrestres, qui ont permis de mettre en évidence son augmentation régulière

et sa modulation par un cycle saisonnier particulièrement fort dans

l’hémisphère nord, qui contient le plus de surfaces continentales et est

le plus peuplé. En été, la croissance de la biomasse végétale par photosynthèse

y absorbe en effet une grande quantité de gaz carbonique, alors qu’en hiver, la

respiration des bactéries qui décomposent cette biomasse, ainsi que le recours

massif au gaz, au charbon et au pétrole pour le chauffage y induisent un

maximum très marqué.

Dans l’hémisphère sud, ce cycle est beaucoup moins marqué en raison de la très grande part qu’y prennent les océans, lesquels prennent le contre-pied des terres émergées en absorbant du gaz carbonique atmosphérique en hiver, lorsque l’eau plus froide dissout mieux ce gaz, et en le rejetant en été lorsqu’ils se réchauffent.

Mais ce réseau ne permet pas d’observer en détail les conséquences d’un phénomène particulier, comme l’effet de la photosynthèse ou celui des défrichements par le feu dans la forêt amazonienne, ou encore une sécheresse anormale dans une région donnée en période de croissance végétale.

Les données de ce réseau de stations terrestres nous montrent l’accumulation du gaz carbonique dans l’atmosphère, mais elles ne permettent pas de quantifier les rôles respectifs à un moment donné des océans, des divers écosystèmes terrestres, ou de l’activité humaine.

Le satellite OCO-2 a été lancé pour fournir chaque jour des données de concentration en gaz carbonique dans l’atmosphère couvrant la quasi-totalité du globe. Il est accompagné par un «train» d’autres satellites qui fournissent des données prises pratiquement au même moment et dont certaines permettront de préciser et de mieux comprendre les résultats.

En particulier, OCO-2 porte un capteur de fluorescence (Solar Induced

Fluorescence : SIF) qui permet de mesurer la fluorescence des végétaux

terrestres (en mer, cette fluorescence existe aussi, mais, émise à une longueur

d’onde de 670 nm, elle est immédiatement absorbée par l’eau en quasi-totalité).

Cette fluorescence est produite lors de la photosynthèse et son intensité

renseigne donc sur le puits de gaz carbonique que constitue la végétation

terrestre. On devrait ainsi, pour une perturbation due à un phénomène

identifié, en diagnostiquer les causes, et suivre l’évolution du panache de

dilution transporté par le vent. Les applications les plus faciles à imaginer

concernent les feux de biomasse, l’effet des grandes concentrations urbaines,

ou celui d’une poussée de plancton en mer dans une région de forte production

primaire comme l’upwelling du Pérou ou des Canaries.

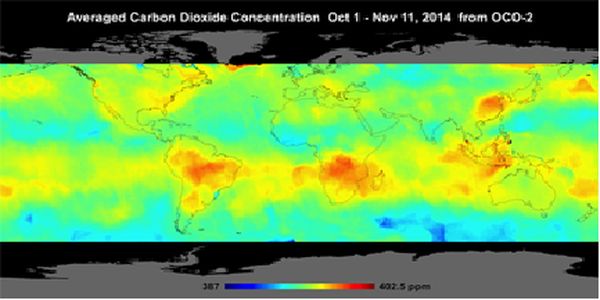

Cinq mois après son lancement, une analyse des premiers

résultats vient de paraître. Elle montre (figure 1)

des concentrations en gaz carbonique comprises entre 387 et 402 ppm, ce qui est

conforme aux connaissances actuelles. Les concentrations les plus élevées se

situent au dessus du Brésil et de l’Afrique du sud vers 15°S. Elles pourraient

avoir été causées par des feux de biomasse en fin de saison sèche. On note

aussi des concentrations fortes entre l’Australie et l’Indonésie, ainsi qu’au

nord de la Chine. Ces premiers résultats sont le fruit d’une synthèse portant

sur un mois de données (du 1er octobre au 11 novembre 2014) et ne permettent

pas de suivre en détail l’évolution des masses d’air enrichies en gaz

carbonique, ni d’en identifier l’origine avec précision. Toutefois, cette

distribution des zones à forte concentration en gaz carbonique est tout à fait

conforme à ce qu’on en connaît déjà et que le

modèle couplé physique biogéochimie développé au Goddard Space Flight

Center de la NASA reproduit à cette saison.

Figure 1 : Concentration globale en gaz carbonique de l’atmosphère entre le 1er octobre et le 11 novembre enregistré par le Orbiting Carbon Observatory-2 de la NASA. Les concentrations en gaz carbonique sont les plus hautes au nord de l’Australie, en Afrique du Sud et au Brésil. (NASA/JPL-Caltech)

Détecter des variations de concentration en gaz carbonique sur une gamme aussi étroite depuis l’espace constitue une véritable prouesse. Cela a nécessité et nécessitera encore un travail de calibration et de validation des données, très délicat étant donné la précision recherchée. Pour cela, OCO-2 a été conçu afin de pouvoir viser sous divers angles des stations terrestres où la concentration en gaz carbonique ainsi que d’autres paramètres sont mesurés depuis le sol jusqu’à la haute atmosphère. Au vu des premiers résultats, le pari semble en bonne voie d’être gagné.

2/2 Banquises : contrastes polaires

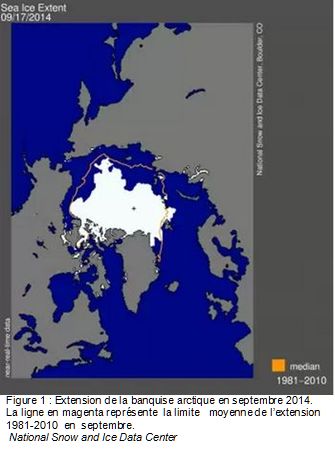

La

banquise

arctique a atteint son minimum d’extension le 17 septembre 2014 avec 5,3

millions km2 (figure 1). Cela n’est pas un record mais c’est

quand même la sixième extension la plus faible depuis 1979, date depuis

laquelle on dispose de mesures satellitaires de l’extension des banquises.

La

banquise

arctique a atteint son minimum d’extension le 17 septembre 2014 avec 5,3

millions km2 (figure 1). Cela n’est pas un record mais c’est

quand même la sixième extension la plus faible depuis 1979, date depuis

laquelle on dispose de mesures satellitaires de l’extension des banquises.

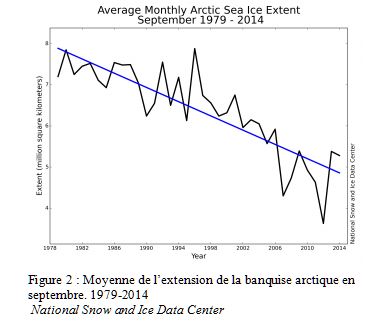

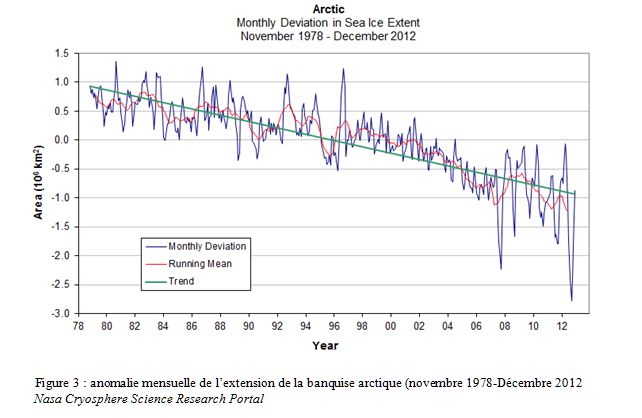

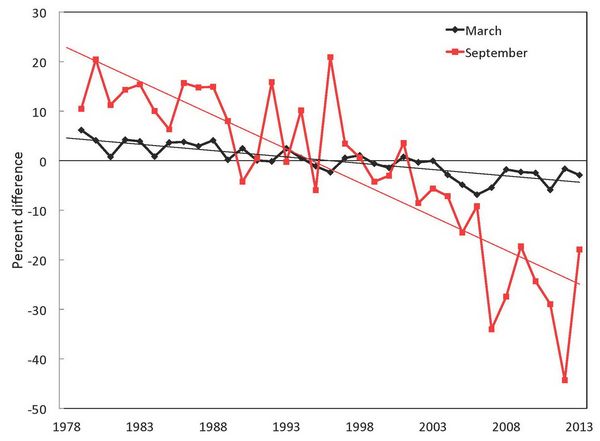

L’extension de la banquise arctique à son minimum en septembre décroît au rythme de 13,3% par décennie (figure 2).

Le minimum absolu d’extension eut lieu en septembre 2012 avec seulement 3,41 millions de km2. La diminution de l’extension de la banquise arctique ne se limite pas à son minimum, elle est générale en toute saison (figure 3).

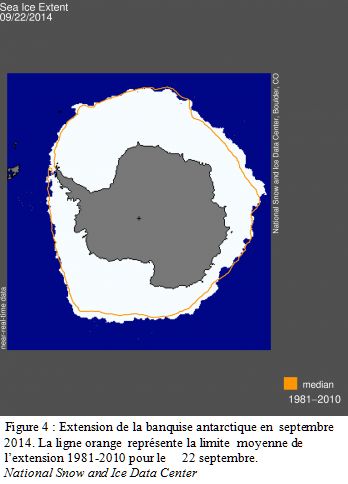

Á l’inverse début octobre 2014 la banquise antarctique

atteignait un record d’extension avec 20,1 millions de km2 (figure 4).

Á l’inverse début octobre 2014 la banquise antarctique

atteignait un record d’extension avec 20,1 millions de km2 (figure 4).

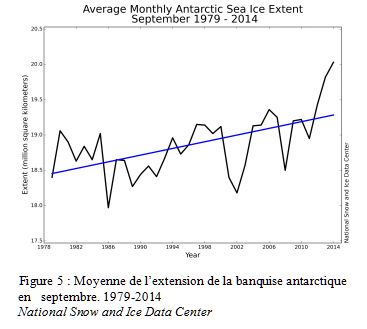

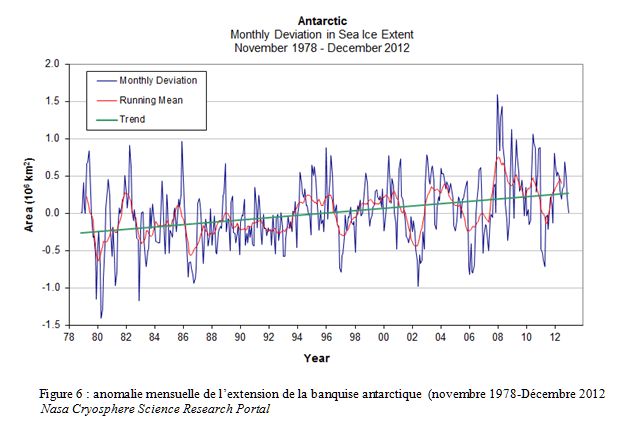

Contrairement aussi à celle de l’Arctique, l’extension de la banquise antarctique ne cesse de croître depuis 1979 (Figures 5 et 6)

Le gain de l’Antarctique (1% par décennie) ne compense pas, loin de là, la perte de l’Arctique qui est trois fois supérieure au gain de l’Antarctique mais ces tendances contraires sont bien réelles.

Nul ne s’étonne évidemment en ces temps de changement climatique de la

diminution de la banquise arctique. L’évolution de la banquise antarctique,

elle, est d’autant plus surprenante que la tendance au réchauffement autour de

ce continent est réelle même si elle est nettement plus faible que dans

l’Arctique. Dans les simulations du cinquième rapport du GIEC,

la température du pourtour du continent Antarctique croît de 1 à 3°C suivant

les scénarios à l’horizon 2081-2100.

Vu la différence de configuration des zones polaires, un océan au pôle nord, un

continent au pôle sud, on ne pouvait s’attendre à ce que leurs évolutions

climatiques respectives fussent identiques. Mais que, concernant la banquise,

elles se fassent en sens inverse mérite explication.

On en est encore aux conjectures avec trois explications possibles résultant, en partie et paradoxalement, du réchauffement climatique lui-même.

L’augmentation de la température de l’océan fragilise la prolongation en mer des glaciers continentaux et favorise leur fonte. L’apport d’eau douce supplémentaire diminue la salinité et fait remonter le point de congélation.

Du fait du réchauffement l’air peut contenir davantage de vapeur d’eau. Il est alors probable qu’une augmentation des précipitations de pluie ou de neige sur l’océan diminuent la salinité comme dans le cas précédent.

Le renforcement des vents d’ouest autour du continent induit un accroissement vers le nord du transport d’Ekman de la glace et des eaux froides de surface depuis le continent Antarctique ce qui facilite la formation de glace. Les modifications induites par le changement climatique dans le champ de pression atmosphérique peuvent y avoir leur part mais on suspecte surtout la diminution depuis la fin des années 1970 de l’ozone au-dessus de l’Antarctique («le trou d’ozone» ) qui modifie de manière importante l’équilibre radiatif de la stratosphère. Dans les années à venir ce déficit d’ozone devrait se résorber atténuant ce phénomène de refroidissement des eaux de surface et contribuant à une augmentation de l’effet de serre…

La réalité, difficile à cerner compte tenu du peu d’observations dans cette

zone, relève peut-être de la combinaison de ces trois explications.

Il est vraisemblable que cette situation soit temporaire et que d’ici quelques

années l’accroissement à l’œuvre de la température de l’air fera fondre la

banquise comme dans l’Arctique et mettra un terme à l’accroissement de son

extension. Mais à quelle échéance ?

Sources :

http://earthsky.org/earth/...increase

http://science.nasa.gov/..._yinyang/

http://rsta.royalsocietypub...130040

Mois de Novembre 2014

1/1 Océanographie opérationnelle : la France leader

européen

Le Service Copernicus de surveillance des océans est délégué à

Mercator-Océan.

Le 11 novembre 2014 la Commission Européenne et Mercator-Océan ont signé un accord qui délègue à Mercator -Océan la mise en place du service Copernicus de surveillance des océans. Ce service ouvrira en Avril 2015.

Copernicus, autrefois GMES, est le «programme européen de surveillance de la Terre» initié par l’Agence Spatiale Européenne et l’Union Européenne en 1998. Ce programme est constitué d’un ensemble complexe de «systèmes» qui collectent des données de sources multiples (observations in situ, observations spatiales) et les traitent pour fournir aux utilisateurs des informations fiables et des prévisions à travers un ensemble de services concernant l’environnement et la sécurité.

Ces services ont trait aux six thématiques suivantes :

milieux terrestres,

milieu marin,

atmosphère,

changement climatique,

gestion des urgences ,

sécurité.

C’est le service «Copernicus marine monitoring service» qui est désormais confié à Mercator-Océan.

C’est le couronnement de vingt ans d’effort. L’histoire commence en effet en juin 1995 à la Chapelle Aubareil dans le Périgord où, à l’initiative de l’argonaute Michel Lefebvre et de Jean-François Minster, une trentaine d’océanographes se sont réunis pour jeter les bases d’une océanographie opérationnelle capable de prévoir l’océan à l’instar de ce que fait la météorologie pour l’atmosphère. Les Institutions convaincues suivront. Ainsi naquit Mercator-Océan mené au succès par Pierre Bahurel.

Son premier bulletin de prévision de l’océan est publié le 17 janvier 2001. C’est une réussite et, tout naturellement, la Commission Européenne confiera à Mercator-Océan en 2009 le soin de coordonner, via le projet expérimental My Ocean, le «Marine Core Service» du programme GMES. Mission accomplie avec succès qui permet maintenant de passer de la phase expérimentale à la mise en place d’un véritable service européen d’océanographie opérationnelle au sein de Copernicus sous la responsabilité de Mercator-Océan.

Ce succès est indissociable de l’autre succès de l’océanographie opérationnelle française évoqué dans la news de septembre 2014 : la création en juillet 2014 de l’«ERIC Euro-Argo» basé à l’Ifremer-Brest.

En effet, en France, les projets Mercator-Océan et Argo ont été complémentaires et menés en très étroite coopération. Il est logique qu’ils se retrouvent au moment de leur «européanisation» et du démarrage du «Copernicus Marine Monitoring Service».

Mois de Septembre 2014

1/1 Euro-Argo ERIC

Une infrastructure de recherche européenne pour l'observation des océans

L’inauguration

de l’ERIC

Euro-Argo a eu lieu à la représentation permanente française à Bruxelles le

17 juillet 2014. La mise en place d'une structure légale européenne (European

Research Infrastructure Consortium, ERIC) pour l'observation in situ des

océans est une première. C'est une étape majeure pour optimiser, pérenniser

et renforcer les contributions européennes au réseau Argo. C’est

l’Ifremer à Brest qui va accueillir cette structure pour une durée d’au moins

cinq ans.

L’inauguration

de l’ERIC

Euro-Argo a eu lieu à la représentation permanente française à Bruxelles le

17 juillet 2014. La mise en place d'une structure légale européenne (European

Research Infrastructure Consortium, ERIC) pour l'observation in situ des

océans est une première. C'est une étape majeure pour optimiser, pérenniser

et renforcer les contributions européennes au réseau Argo. C’est

l’Ifremer à Brest qui va accueillir cette structure pour une durée d’au moins

cinq ans.

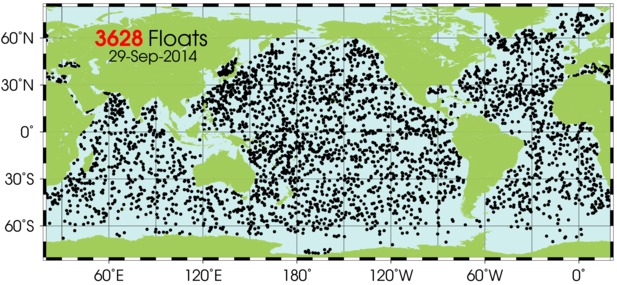

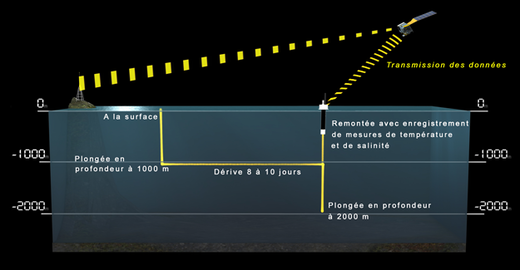

Le programme international Argo a été lancé en 2000 par l’Organisation Météorologique Mondiale et la Commission Océanographique Intergouvernementale. L’objectif était de déployer dans tout l’océan un réseau global de 3 000 flotteurs profilants autonomes qui mesurent en temps réel et tous les dix jours la température, la salinité et la pression (profondeur) sur les 2000 premiers mètres de l’océan.

L’objectif de 3 000 flotteurs a été atteint en 2007. Le 29 septembre 2014 il y en avait 3 628.

Le cycle de fonctionnement de ces flotteurs apparaît sur la figure suivante :

Pour maintenir le réseau, environ 800 flotteurs sont déployés chaque année, chaque flotteur ayant une durée de vie d’environ 4 ans. C’est le premier véritable réseau d’observation opérationnelle de l’océan. Pour sa part la France déploie chaque année 60 à 80 flotteurs. Le réseau Argo est la principale composante in situ du système mondial d’observation des océans qui, avec son volet spatial complémentaire (altimétrie satellitaire) est indispensable pour :

la prévision météorologique à long terme,

la connaissance de la variabilité climatique aux échelles saisonnières et décennales,

l’observation du changement climatique dans les océans,

la fourniture des données essentielles pour alimenter les modèles de prévisions océaniques indispensables à la mise en place d’un véritable service de prévision océanique à diverses échelles de temps et d’espace ( Mercator-Océan, Copernicus Marine Monitoring Service).

![]()

Trente pays apportent leur contribution au programme Argo.

En 2006 douze pays européens se sont mis d’accord pour mettre en place à terme une structure pérenne afin d’organiser dans la durée une contribution importante de l’ Europe à Argo : Euro-Argo.

Ces douze pays sont : France, Allemagne, Grande-Bretagne, Italie , Espagne, Pays-Bas, Norvège, Irlande, Grèce, Portugal, Pologne et Bulgarie ( l’Espagne, l’Irlande et la Bulgarie ne sont pas membres fondateurs de l’ERIC mais devraient adhérer dans l’année qui vient – Portugal, Turquie, Suède à plus long terme).

C’est la France qui a coordonné Euro-Argo qui a été labellisé en 2006 comme infrastructure de recherche dans la première feuille de route « ESFRI » (European Strategy Forum Research Infrastructures) .ESFRI est un instrument stratégique pour développer l’intégration scientifique de l’Europe et faciliter les initiatives multilatérales pour le développement d’infrastructures de recherche aux niveaux européen et international.

Huit ans après, l’initiative Euro- Argo qui fournit chaque année entre 150 et 200 flotteurs est un succès et change de statut passant à une véritable institution européenne pérenne dédiée à l’observation des océans. La contribution européenne au réseau Argo devrait attendre 250 flotteurs/an dans les années qui viennent.

Le lendemain de l’inauguration d’ERIC Euro-Argo, s’est tenue la première réunion du conseil de l’ERIC qui a élu comme président P.Y. LeTraon de l’Ifremer, déjà responsable d’Euro-Argo. La direction de l’ERIC à Brest sera assurée par S.Pouliquen qui sera assistée d’un comité de direction (management board). L’ERIC Euro-Argo assurera la coordination et l’achat de flotteurs européen et devrait employer 3 à 4 personnes d’ici quelques années (deux pour le moment).

La première priorité et le premier défi pour Argo sont de maintenir le réseau actuel sur les 10 à 20 prochaines années. Le second défi est de faire évoluer le réseau pour répondre à de nouvelles questions scientifiques et élargir son domaine d’applications.

Des évolutions seront ainsi progressivement apportées :

couverture des zones polaires et des mers marginales,

extension aux plus grandes profondeurs

et ajout de capteurs biogéochimiques mesurant des paramètres tels que la teneur en l’oxygène, en chlorophylle a, en carbone organique particulaire, en nitrate.

Pour sa part la France s’investit pleinement dans cette évolution du programme Argo : Le projet Equipex NAOS va permettre la mise en place en France de cette nouvelle phase d’Argo.

Mois de Juillet 2014

1/1 Lancement du satellite OCO-2 de mesure du CO2.

Le satellite de la

NASA, «Orbiting Carbon

Observatory-2» (OCO-2) a été lancé avec succès de la base de

Vandenberg le 2 juillet.

Le satellite de la

NASA, «Orbiting Carbon

Observatory-2» (OCO-2) a été lancé avec succès de la base de

Vandenberg le 2 juillet.

C’est le premier observatoire spatial dédié à la mesure et à l’étude du gaz

carbonique de l’atmosphère. S’il porte le numéro 2 c’est qu’il a eu un

prédécesseur malheureux OCO-1 perdu dès son lancement en 2009. OCO-2 collectera

des mesures du CO2 atmosphérique avec la précision, la résolution et

la couverture nécessaires pour caractériser les «sources et les

puits» de CO2 aux échelles régionales et pourra aussi

quantifier les variabilités saisonnières de CO2. Le gaz carbonique

est le principal gaz à effet de serre dont l’accroissement dans l’atmosphère

contribue au réchauffement climatique. Les sources de ce CO2

supplémentaire d’origine anthropique (industrie , transport , énergie ,

activités agricoles etc…) ne sont pas réparties uniformément sur Terre et les

observatoires traditionnels ne permettent pas d’en faire une cartographie

précise. De même les réponses physiques et biochimiques des milieux océaniques

et terrestres à cette surproduction varient d’une région à l’autre. Globalement

la moitié du gaz carbonique émis est absorbé par les océans et les continents.

On parle alors de puits qui stockent une partie du CO2 émis. Il

s’agit des océans et de la biosphère océanique ou continentale. Pas plus que

celle des sources, la cartographie et l’intensité des puits n’est accessible

aux observatoires traditionnels. C’est l’objectif d’OCO-2 de remédier à

la méconnaissance des sources et des puits du CO2 et d’améliorer

ainsi la compréhension du cycle du carbone, des processus naturels et des

activités humaines qui contribuent à modifier l’abondance et la distribution

géographique des gaz à effet de serre. Ces sources et puits ont une signature

dans la quantité de CO2 contenue dans l’atmosphère : supérieure à la

moyenne au-dessus des sources et inférieure au-dessus des puits. Ce sont ces

différences que détectera OCO-2 dont on déduira les régions source et

les régions puits.

L’instrument de mesures est constitué de trois spectromètres qui effectuent des

mesures simultanées de l’absorption de la lumière solaire réfléchie par la

surface de la Terre à trois longueurs d’onde du proche infrarouge. Les mesures

sont faites au rythme de 3 par seconde et couvrent une surface au sol de

3 km2. Deux des longueurs d’onde sont caractéristiques du

CO2 et permettent de calculer la quantité de CO2 dans la

colonne d’air. La troisième est caractéristique de l’oxygène. Cette dernière

sert de référence. En effet pour être certain d’avoir une évaluation précise de

la quantité de CO2 mesurée il faut la comparer à celle d’ un autre

gaz atmosphérique dont la concentration moléculaire est constante, bien connue

et uniformément répartie dans l’atmosphère. C’est le cas de l’oxygène.

Le satellite OCO-2 circule sur une orbite polaire héliosynchrone à

705 Km d’altitude.

Cette orbite a été choisie (altitude et inclinaison sur l’équateur) de sorte

que la précession du plan d'orbite – c’est à dire la rotation de sa ligne

d'intersection avec l'équateur- soit de 0,986 degré /jour, exactement la même

que celle du soleil dans son mouvement apparent le long de l’écliptique. Cette

synchronisation se traduit par une caractéristique intéressante : l'angle du

plan d'orbite d'OCO-2 avec le Soleil est constant.

L'heure du lancement a été choisie de sorte que la direction du Soleil fasse un angle d'un peu moins de 24 degrés avec le plan d'orbite. De la sorte, pour la section qui n'est pas dans l'ombre de la Terre, le survol de la zone équatoriale a lieu à une heure locale proche de 13h35, (tandis que les passages de nuit se font a 1h35). Ainsi, en l'absence de couverture nuageuse, les instruments d'OCO-2 bénéficient des conditions les plus favorables : le Soleil est au plus haut et l'intensité de la lumière réfléchie qu'ils mesurent est maximum.

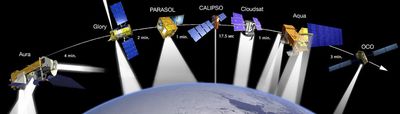

Il fait partie de la

formation A-Train (Afternoon Train) constituée de 7 satellites

franco-américains dédiés à l’étude de l’atmosphère terrestre qui se suivent à

quelques minutes d’intervalle sur la même orbite. Cette configuration permet de

corréler entre elles les mesures effectuées par les différents satellites du

A-Train. Ainsi, par exemple les mesures du sondeur infra-rouge (AIRS) du

satellite Aqua seront utilisées pour affiner celles d’OCO-2.

Il fait partie de la

formation A-Train (Afternoon Train) constituée de 7 satellites

franco-américains dédiés à l’étude de l’atmosphère terrestre qui se suivent à

quelques minutes d’intervalle sur la même orbite. Cette configuration permet de

corréler entre elles les mesures effectuées par les différents satellites du

A-Train. Ainsi, par exemple les mesures du sondeur infra-rouge (AIRS) du

satellite Aqua seront utilisées pour affiner celles d’OCO-2.

La durée de minimale prévue d’OCO-2 est de deux ans.

Mois de Mars 2014

1/1 Année 2013, quel classement au palmarès des années les plus chaudes ?

Les années se suivent répétant chaque fois le même suspense : quel est le classement de l’année au palmarès des années les plus chaudes ?

Même question d’ailleurs pour l’extension des banquises arctiques.

On pourrait même imaginer un scénario pour illustrer la lutte des

"climatosceptiques" contre la doxa des "réchauffistes". Les

premiers, devenant dans l’ombre ultraécologistes, ne se chaufferaient plus, ne

feraient que de la marche à pied ou du vélo deviendraient végétariens …..avec

l’espoir que la température de la Terre ne monterait plus voire même

baisserait pour faire triompher leur thèse ; les seconds en revanche se

chaufferaient au fuel et au charbon ne circuleraient qu’en grosse cylindrée et

iraient même jusqu’à incendier les forêts pour être certains que la température

augmente…

Nous n’en sommes pas encore là… mais il est nécessaire de rappeler qu’une année

ne fait pas le climat et que sa variabilité interannuelle peut masquer son

évolution à long terme. Les chiffres publiés, et utilisés ici, pour l’année

2013 ne sont que des balises sur un chemin cahoteux et accidenté comme

l’indication de l’altimètre de l’alpiniste qui cherchant à atteindre un sommet

est parfois obligé de descendre...

La teneur en CO2 de l’atmosphère.

Le gaz carbonique, gaz à effet de serre emblématique, est un acteur du climat. Mais sa production intensive par les activités humaines masque complètement ses variations et sa variabilité «naturelles». Imperturbablement sa concentration dans l’atmosphère augmente chaque année. Elle était de 316 ppm en 1959, elle fut de 396,5 ppm en 2013 soit une augmentation de 26% (Figure 1).

Comme chez l’homme il y a loin de la parole aux actes, en dépit du protocole de Kyoto et des 19 COP (Conférence des Parties au protocole de Kyoto) qui ont suivi, le taux d’accroissement du CO2 dans l’atmosphère augmente lui aussi : sur la décennie 1994-2003 il était de 1,9 ppm/an, il fut de 2,1 la décennie suivante (2004-2013). Voir aussi la news d'avril 2013.La température moyenne

L’évolution de la température globale, versions NASA etNOAA est représentée sur la figure 2.

Dans sa lettre 138 de l’hiver 2013-2014 l’ECMWF (European Centre for Medium-Range Weather Forecasts) fait le point sur les anomalies de la température globale de la Terre en 2013 à partir des données de la NOAA, de la NASA et du Hadley Center. La NOAA place 2013 au 4ème des années les plus chaudes, la NASA au 6ème et le Hadley Center au 7ème. Par rapport à la température moyenne de la période 1981-2010 les anomalies mesurées sont de 0,19 pour la NASA et 0,20 pour les deux autres. La différence entre les trois est donc très faible : 0,01°C et il ne faut pas accorder beaucoup d’importance à ces différences de leur classement annuel

Depuis 1998 l’anomalie de température globale par rapport à la moyenne 1951/1980 a oscillé selon la NOAA entre 0;65 pour 2005 et 0,43 pour 2000. Á l’exception de 1998 les dix années les plus chaudes depuis 134 ans ont eu lieu depuis 2000. L’année 2013 en fait donc partie et tient bien son rang. Les trois agences mettent nettement en tête les années 2005 et 2010 : entre +0,24 et +0,26 par rapport à la moyenne 1981-2010. Elles étaient toutes deux des années El Niño très marqués. A l’inverse pour les années les plus froides (1999-2000 et 2008) qui étaient des années La Niña persistantes les anomalies se situaient entre -0,01 et +0,1. On sait maintenant que c’est une propriété générale : les années El Niño sont des années «chaudes» et inversement les années La Niña sont relativement froides (figure 3). L’année 2013 année neutre : niNiño, ni Niña, est bien à sa place dans le classement.

La température moyenne y fut de 14°6 soit 0,6° supérieure à la moyenne 1951-1980.

La banquise Arctique

C’est en septembre que la banquise arctique est à son extension minimum (figure 4). Elle fut de 5,10 millions de km2 le 13 septembre 2013. Soit 1,7 millions de km2 de plus qu’en septembre 2012 mais 1,12 millions de km2 de moins que la moyenne du minimum entre 1981 et 2010. L’année 2012 fut l’année record d’extension minimum de la banquise (figure 4). Elle ne fut que de 3,4 millions de km2 en septembre.

L’année 2012 fut pourtant une année plus froide que 2013 (voir news de janvier 2013). Il n’y a pas de corrélation entre les variations interannuelles de la température globale et celles de l’extension de la banquise arctique qui répond aux variations climatiques régionales dont l’amplitude est importante.

Figure 5 : Évolution des anomalies d'extension de la banquise par rapport à la moyenne 1981-2010 pour le mois de mars (extension maximum en hiver courbe noire) et le mois de septembre (extension minimum en été courbe rouge). NAA Arctic Report Card 2013Il existe deux propriétés de la banquise qui atténue cette variabilité interannuelle de la banquise et intègre le plus long terme : l’âge de la glace d’une part et son épaisseur d’autre part. La glace dite de première année est celle qui ne survit pas à la saison de fonte en été. C’est aussi la moins épaisse et, par définition, elle ne contribue pas au maintien du stock de glace de l’Arctique qui, pour se maintenir, doit être alimenté par des glaces qui survivent au dégel et passent le cap des années. En 2012, record absolu du minimum d’extension estivale de la banquise, la glace de première année a représenté en mars au moment maximum de la banquise 78% du pack. Ce fut à peine moins en 2013 : 75%. En mars 1988 cela représentait 58%. En mars toujours, faute d’alimentation, les glaces les plus vieilles (4 ans et plus) sont en diminution constante : 26% de la couverture en 1988, 19% en 2005 et 7% en 2013….

La mesure de l’épaisseur de la glace se fait par observation aérienne et par satellite (Cryosat 2 de l’ESA) depuis 2011.Entre 2011 et 2013 elle a diminué de 32 cm passant de 2,26 à 1,94 mètres.

Si parfois, comme en 2013, l’extension de la banquise en été peut connaître un sursaut, la constance de la diminution de son épaisseur et de l’augmentation de la part qui ne survit pas au premier été ne peut laisser aucun doute sur son évolution. Son dernier refuge : l’extrême nord du Canada et du Groenland où les conduisent les courants marins associés à la circulation de la Mer de Beaufort.

Le niveau de la mer

Le niveau de la mer est un excellent indicateur du changement climatique puisqu’il intègre l’aspect thermique (l’océan reçoit 90% de la quantité de chaleur induite par l’augmentation de l’effet de serre) et les mouvements d’eau dont surtout, aux échelles climatiques, la fonte des calottes polaires et de glaciers.

De 1993 à 2013 le niveau de la mer s’est élevé au rythme moyen de 3,26 mm/an (figure 6). La courbe montre qu’il y a des fluctuations relativement importantes dans cette ascension et que même parfois le niveau baisse. Ce fut le cas en 2011-2012. Puis remonte assez rapidement (2012-2014). Ce sont encore les variations interannuelles qui sont en cause et une fois de plus ENSO (El Niño Southern Oscillation). Pendant El Niño le réchauffement du Pacifique Équatorial bouleverse aussi la circulation atmosphérique, le régime des précipitations et leur répartition. C’est l’océan qui en profite et son niveau s’élève. Pendant La Niña la situation s’inverse, le niveau de l’océan baisse masquant temporairement les effets du changement climatique : c’est ce qui s’est produit avec La Niña 2011-2012. Ensuite la situation s’est rétablie et le niveau de la mer continue son ascension, atteignant même en 2013 un taux d'élévation trois fois supérieur à la moyenne, soit 1 centimètre/an..

Comme chacun sait les années se suivent et ne se ressemblent pas, mais ces caprices climatiques pluriannuels ne doivent pas masquer le mouvement de fond que l’accroissement constant des gaz à effet de serre insensibles aux fantaisies climatiques induit inexorablement.

L’année 2013 fut de ce point de vue une année standard.

L’année 2014 sera peut-être plus originale car nettement plus chaude : le NCEP (National Climate Prediction Center) de la NOAA évalue à 50% les chances d’occurrence d’un évènement El Niño à l’été ou à l’automne.

Mois de Janvier/Février 2014

1/1 Un point sur les satellites disponibles pour la météorologie et l'océanographie

Ce texte fournit une mise à jour sur l'observation spatiale en matière d'océanographie et de météorologie. Il est destiné à rafraîchir l'information donnée au début 2013 sur le même sujet.

LES SATELLITES METÉOROLOGIQUES OPERATIONNELS

L'année 2012 avait vu le lancement de deux satellites météorologiques européens :

le géostationnaire MSG-3 (rebaptisé Météosat-10)

et le satellite à défilementMetOp-B.

Tous deux sont devenus pleinement opérationnels en 2013. C'est EUMETSAT qui assure le traitement des données, en particulier pour une diffusion en temps réel aux centres météorologiques. Ainsi, à Météo France, les données de ces satellites sont assimilées dans les modèles de prévision depuis juillet 2013.

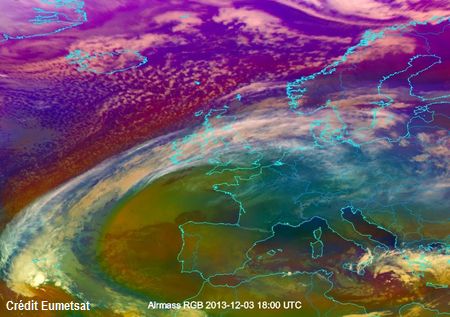

Image du satellite Meteosat 10 capturée le 3 décembre 2013 à 18:00 UTC.

Elle montre un front froid qui s'étend de la mer Baltique au Danemark, à l'Angleterre et au Pays de Galles allant jusque dans l'Atlantique vers les Açores.

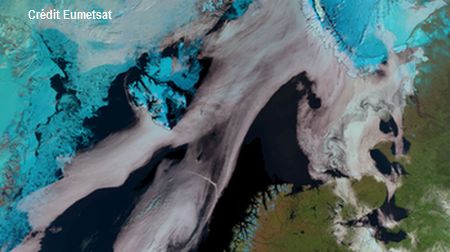

Image du satellite Metop-B capturée le 6 juin 13 à 09:49 UTC.

Elle montre les glaces (couleur cyan) autour de Svalbard et de la côte est du Groenland.

Concernant les satellites météorologiques équivalents exploités hors de l'Europe, il n'y a pas de changement, le géostationnaire japonais HIMAWARI-9 doit être lancé en 2014.

AUTRES MISSIONS SATELLITAIRES DESTINÉES A L'OBSERVATION DE L'ATMOSPHÈRE

Conçue pour l'observation coordonnée de la température, de l'humidité, des nuages et des aérosols dans l'atmosphère, la configuration des satellites «Aqua-Train» a vu la fin de la mission Parasol. Ce satellite, initialement prévu pour 2 ans, a été "éteint" par le CNES le 18 décembre 2013, soit 9 ans jour pour jour après son lancement.

La configuration actuelle de l'«Aqua-Train» comprend :

GCOM-W1,

Aqua,

Cloudsat,

Calipso,

Aura.

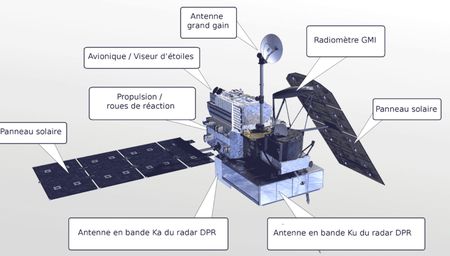

Par ailleurs, le programme GPM (Global Precipitation Measurement) correspond à un ensemble de missions dont l'orientation scientifique est très semblable, et qui doit comprendre dans le futur un satellite principal «GPM Core Observatory» (équipé d'instruments micro-onde actifs et passifs), plus plusieurs autres satellites équipés d'instruments micro-onde passifs.

Le satellite GPM Core Observatory a été lancé avec succès, comme prévu le 27 février 2014, de la base de Tanegashima au sud du Japon.

Il emporte deux instruments micro-onde :

un radar précipitation (DPR),

et un imageur micro-onde (GMI).

La mission GPM a été développée conjointement par les agences spatiales américaine, japonaise et brésilienne : NASA, JAXA et INPE.

CONSTELLATION GALILEO

Comme les autres constellations de satellites de navigation (telles que la constellation GPS) la constellation européenne Galileo est appelée à fournir une opportunité d'observation de l'atmosphère que l'on peut obtenir en déployant des récepteurs de signaux sur terre ou sur des satellites en orbite basse.

4 satellites de la constellation Galileo sont déjà en orbite. Il était initialement prévu d'en lancer deux autres en 2013, mais ces deux lancements ont été retardés. Le plan initial qui prévoyait le déploiement de 18 satellites pour la fin 2014 ne sera sûrement pas tenu.

OBSERVATION DE LA SURFACE DE L'OCÉAN : DIFFUSIOMÉTRES ET ALTIMÉTRES

Il y a maintenant deux satellites européens MetOp diffusant en temps réel des données diffusiométriques relatives à la surface océanique. De plus le satellite indien Oceansat-2 , lancé depuis 2009, voit maintenant ses données accessibles en temps réel sur tout le globe.

Les modèles de prévision opérationnels bénéficient donc maintenant des données d'au moins 3 diffusiomètres (au lieu d'un seul un an auparavant). Les plans concernant les futurs diffusiomètres (RapidScat ,SWIM sur CFOSAT, etc...) sont inchangés.

Dans le domaine de l'altimétrie, Jason-2 est toujours opérationnel, alors que Jason-1 a cessé son activité suite à une panne le 21 juin 2013.

Il n'y a pas de changement du côté de Cryosat-2 qui poursuit sa contribution à l'altimétrie, ainsi que sa mission d'observation des glaces.

Muni de l'altimètre AltiKa (en bande Ka), le satellite franco-indien SARAL a été lancé avec succès le 25 février 2013. Le traitement et la diffusion de ses données ne sont pas encore pleinement opérationnels, mais celles-ci ont déjà fait l'objet de nombreuses études. Un premier atelier de vérification des produits a eu lieu en août 2013, organisé en France par le CNES. Un deuxième atelier est prévu à Ahmedabad (Inde) du 22 au 24 avril 2014.

Voir : http://smsc.cnes.fr/SARAL/Fr/

POUR EN SAVOIR PLUS

Le site web de l'OMM

: http://www.wmo-sat.info/oscar

permet une analyse des systèmes d'observation passés, existants et futurs, pour

l'atmosphère et ses milieux connexes. Il permet à l'internaute de se documenter

sur différents aspects des systèmes d'observation (besoins et lacunes en

observation par rapport à diverses applications). En cliquant sur

«satellite capabilities» il permet d'accéder («à la

carte» et de manière interactive) à une revue de tous les satellites

d'observation passés, existants et futurs, ainsi qu'à une fiche technique

décrivant chaque instrument, chaque satellite et chaque programme

satellitaire.

ACRONYMES

AltiKa : Altimètre embarqué sur le satellite

SARAL

CFOSAT : Satellite franco-chinois :

Chinese-French Oceanic

SATellite

DPR : Dual-frequency Precipitation

Radar (Radar du satellite GPM Core Observatory)

EUMETSAT : European Organisation for

the Exploitation of Meteorological

Satellites

GCOM-W1 : Global Change

Observation Mission

1-Water

GMI : GPM Microwave

Imager (imageur micro-onde de GPM)

GPM : Global Precipitation

Measurement

HIMAWARI : Programme japonais de satellites météorologiques

géostationnaires

INPE : Agence spatiale brésilienne

JAXA : Japan Aerospace

Exploration Agency

METOP-B : Meteorological Operational

Polar Satellite (en français Satellite

Météorologique Polaire Opérationnel)

MSG-3 : Troisième satellite météorologique Meteosat

de la deuxième génération (Meteosat Second Generation) rebaptisé

Meteosat 10

OceanSat : Programme indien de satellites destinés à

l'observation de l'océan

OCO : Orbiting Carbon

Observatory

OMM : Organisation Météorologique

Mondiale - en anglais WMO : World

Meteorological Organization

QuikScat : Quick Scatterometer.

Satellite d'observation terrestre de la NOAA qui fournit des informations sur

la vitesse et la direction des vents.

RapidScat : Rapid Scatterometer,

instrument qui sera installé par la NASA sur la station spatiale internationale

en 2014

SARAL : Satellite with Argos and

ALtika

SWIM : Altimètre destiné à être embarqué sur CFOSAT